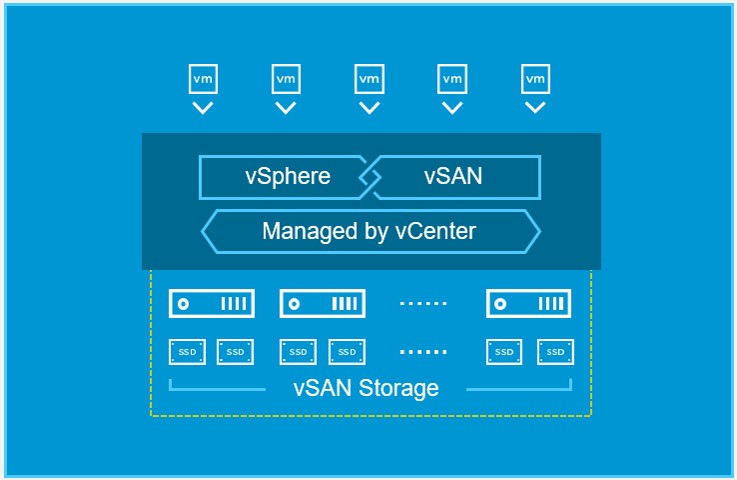

VMware vSAN 通过 vSphere 原生的高性能体系结构支持业界领先的超融合基础架构解决方案。vSAN是 Software-Defined Data Center 的核心构造块。vSAN 作为唯一的 vSphere 原生软件定义的存储平 台,可帮助客户安全地向超融合基础架构 (HCI) 转变,同时可降低 IT 成本并且可为将来的硬件、云计 算和应用变革准备好敏捷性解决方案。vSAN 借助业界首个原生 HCI 加密解决方案提供经过闪存优化的安 全存储,所需成本仅为专门构建的传统存储和效率低下的 HCI 解决方案的一小部分。vSAN 将与服务器连 接的存储汇集到一起,提供适用于任何虚拟化工作负载(包括关键业务应用、虚拟桌面、远程 IT、灾难恢 复和 DevOps 基础架构)的恢复能力极强的共享数据存储。

vSAN设计基本要求 vSAN 软件需要: ● VMware vSphere 5.5/6 以上,建议vSphere 6.5 U1以上 ● vSAN 的软件许可 ● Horizon View(高级版/企业版)包含vSAN(高级版)许可 vSAN 集群需要: ● 至少有三个节点,其中存放Witness的第三个节点 - 可以是物理机、虚机或云主机上 ● 因此,虽然需要至少三个节点,但允许至少两台物理机 ● 每个主机1~5个磁盘组 ● 每个磁盘组仅配置1块用于缓存的SSD ● 每个磁盘组配置1~7块用于持久化存储的HDD或SSD vSAN ESXi 集群成员需要: ● 由 vSAN 提供支持的 VMkernel 端口 关于VMware vSAN的更多要求可参考本站之前的文章有比较详细的介绍: x86服务器虚拟化技术介绍(3) vSAN 支持中心 https://www.vmware.com/cn/support/virtual-san.html

从上面的介绍可以看出,要想在硬件上完全达到vSAN的设计要求,是一般学习者很难做到的。在这种情况 下,为了可以模拟出VSAN的使用环境,我们可以通过在单台ESXi主机上安装ESXi虚拟机的方法来实现模拟 VSAN集群环境,从而达到学习的目的。这种方法不受VMware支持,所以不要采用的实际的生产环境中。但是 是一个用来了解和学习VSAN知识的好方法。本篇就来详细介绍一下搭建方法。

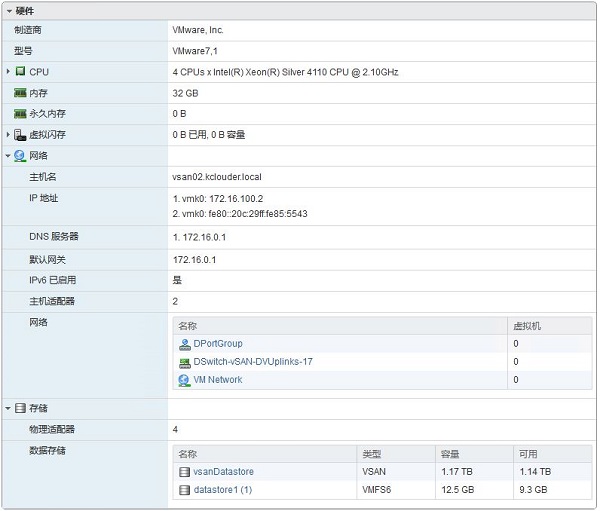

环境准备 1,软件版本 ● ESXi版本:VMware-ESXi-6.7.0-8169922-LNV-20180404 ● vCenter版本:VMware-VCSA-all-6.7.0-8217866 2,节点配置 ● 本次演示在一台物理机上部署4台ESXi虚拟机,三台用来部署vSAN,一台用来安装vCenter。 ● 每台vSAN节点配置4vCPU,32G RAM,三块硬盘分别为20G,40G,400G。 ● 20G硬盘用来安装ESXi,40G硬盘用来模拟SSD缓存盘,400G硬盘用作容量盘。 ● 配置两块网卡,其中一块用于创建分布式交换机用来跑vSAN流量。

3,网络配置

vSAN-node1

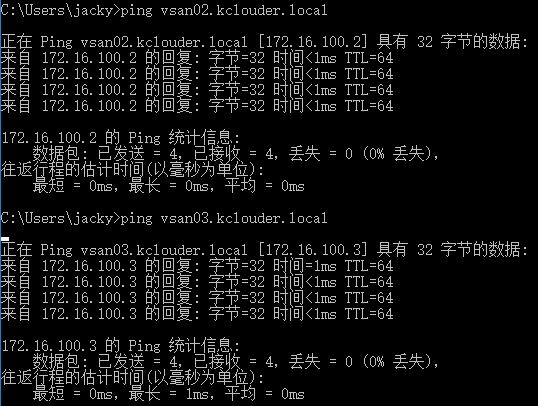

hostname: vsan01.kclouder.local,IP:172.16.100.1

vSAN-node2

hostname: vsan02.kclouder.local,IP:172.16.100.2

vSAN-node3:

hostname: vsan03.kclouder.local,IP:172.16.100.3

vCenter主机:

hostname:vchost.kclouder.local,IP:172.16.0.10

vCenter Appliance:

hostname:vc.kclouder.local,IP:172.16.0.9

注意事项 ● 所有虚拟机的CPU需要开启“向客户机操作系统公开硬件辅助的虚拟化”功能。 ● 虚拟机硬盘不要使用“Thin Provision”模式,这样会严重影响性能导致VSAN部署失败。 ● ESXi虚拟机安装完成后,需要修改hostname。 ● 节点的hostname需要能够解析,所以要确保实验环境中有DNS服务器工作正常。 ● 需要NTP服务器用于时间同步。

安装vCenter vCenter安装过程这里就略过,不作详细介绍了,如果对VC安装不熟悉,可以参考本站关于部署NUTANIX 的文章中关于安装VC的介绍。链接如下: Nutanix-CE版部署指南(一)

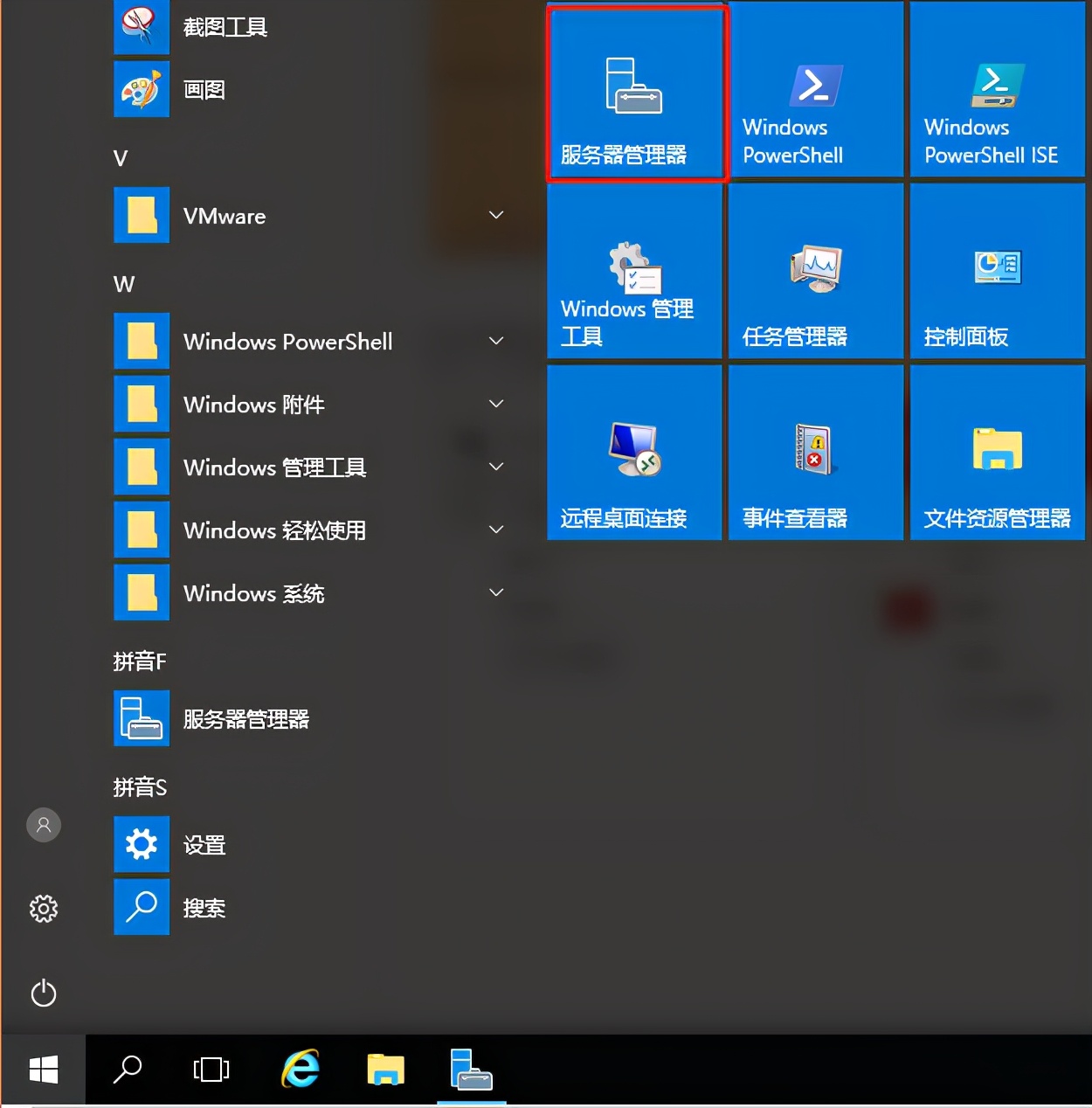

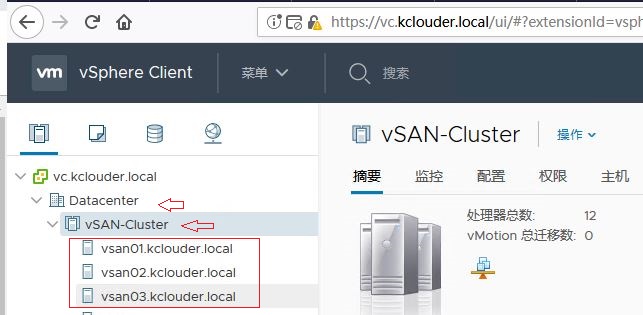

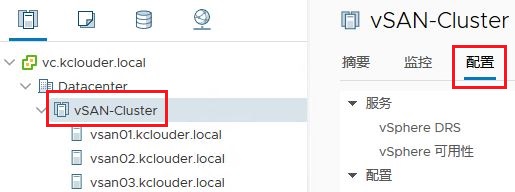

配置VSAN 1,以上所有环境准备就绪以后,我们就可以开始配置VSAN集群了,首先在VC中创建数据中心和集群,然后 添加主机,将三个节点假如到集群中。 ● 数据中心:Datacenter ● 集群:vSAN-Cluster ● 添加节点时需要使用FQDN,不要使用IP地址

2,标注SSD 我们使用的是HDD机械硬盘,VSAN需要使用SSD闪存盘作为其缓存层,所以我们需要将HDD模拟成SSD来 满足这一要求。在节点的配置选项下,点击“存储设备”,找到需要标记为SSD的硬盘,然后点击“标记为闪 存磁盘”进行修改。如下图我们将40G硬盘标记为闪存盘,用作VSAN的缓存层。将三个节点的40G硬盘都进 行标记操作。

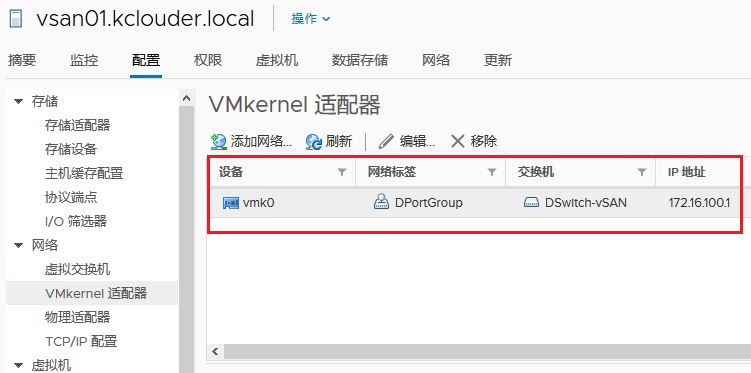

3,创建分布式交换机(Distributed Switch) 右建点击“Datacenter” -- "Distributed Switch" -- "新建Distributed Switch",命名为 “DSwitch-vSAN”,选择“6.6.0版本”,上行链路设置为“4”,并创建默认端口组“DPortGroup”。

4,向分布式交换机中添加主机,右键点击“DSwitch-vSAN”,选择“添加和管理主机”,选择“添加主机”, 然后点击“ 新主机”进行添加。

5,选择vmnic1,这里vmnic1为没有使用的网卡,专门用来创建分布式交换机的,然后点击“分配上行链 路”。对三个节点的vmnic1执行同样的操作。

6,分配VMKernel网卡,选择vmk0,然后点击“分配端口组”,将VMKernel网卡分配到分布式交换机中。对 三个节点执行同样的操作。

7,添加VSAN NETWORK,选择节点,然后点击“配置” -- “VMKernel适配器”,点击“vmk0”,然后点击“编 辑”,勾选“vSAN”。对三个节点执行同样的操作。

8,修改完成后,VMkernel及vSAN的网络将使用分布式交换机。

9,在集群中启用VSAN 点击“vSAN-Cluster”,在“配置”选项卡下,选择“vSAN”,然后点击右上角的“启用VSAN”。

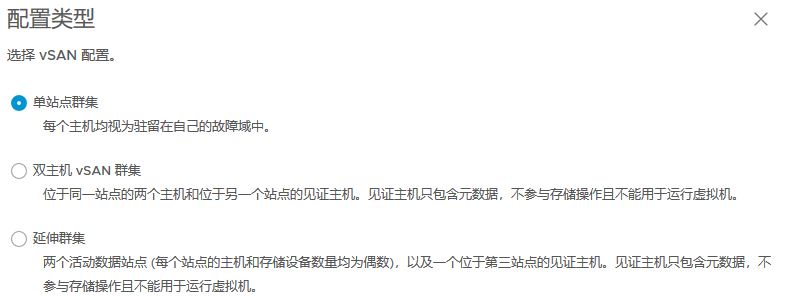

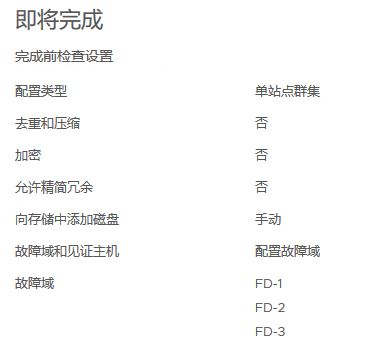

10,选择将VSAN配置为“单点集群”,每个节点为独立的故障域。

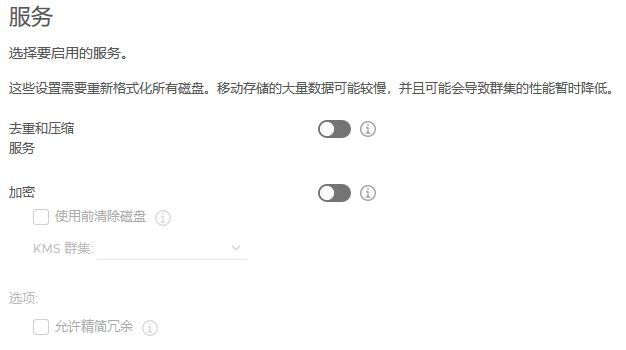

11,这里由于性能原因,没有开启去重和压缩及加密服务,因为这样会带来很大的磁盘开销。

12,声明磁盘,将40G的SSD声明为缓存盘,将400G的HDD声明为容量盘。

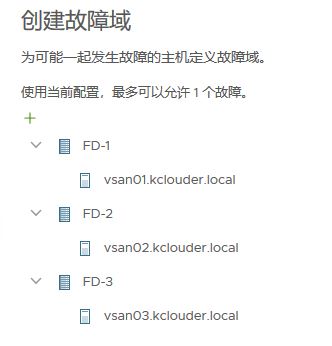

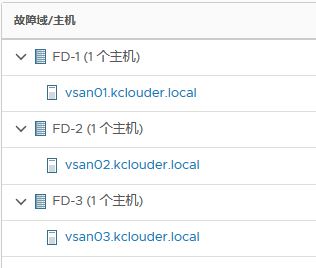

13,创建故障域,为每个节点创建一个独立的故障域。

14,配置完毕后,检查配置无误后,完成配置工作。

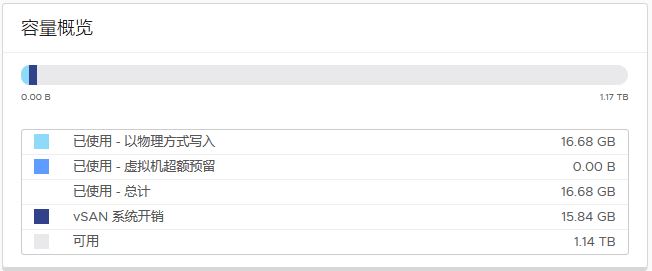

15,等待VSAN启动完成,这里依照主机性能不同时间有所差异,可以点击刷新按钮查看最新状态。VSAN启 用成功后如下图。

查看VSAN状态 1,检查磁盘组,可以看到每个节点中包含一个磁盘组,每个磁盘组中有两个磁盘。由于不是全闪配置,所以 类型为混合。

2,查看故障域,这里每个主机为一个独立的故障域,三台主机,所以最多允许一个故障域故障。

3,查看虚拟对像,虚拟对像主机是虚拟机的磁盘文件在集群存储中的详细信息

4,VSAN配置完成后,由三个节点组成的分布式存储为“vsanDatastore”

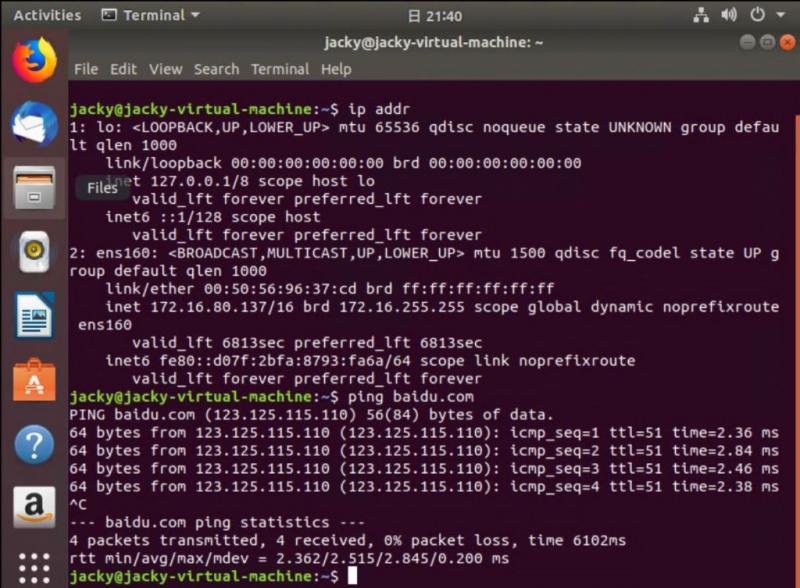

5,在VSAN中创建虚拟机,这里虚拟机网络也使用了VSAN的分布式交换机。但是在实际应用中,不建议将虚 拟机网络与VSAN网络共用,以避免影响集群稳定性。

允许随意转载;但,请点赞!点赞-NMBHOST:NMB HOST » (转)基于VMware ESXi虚拟机搭建VSAN集群

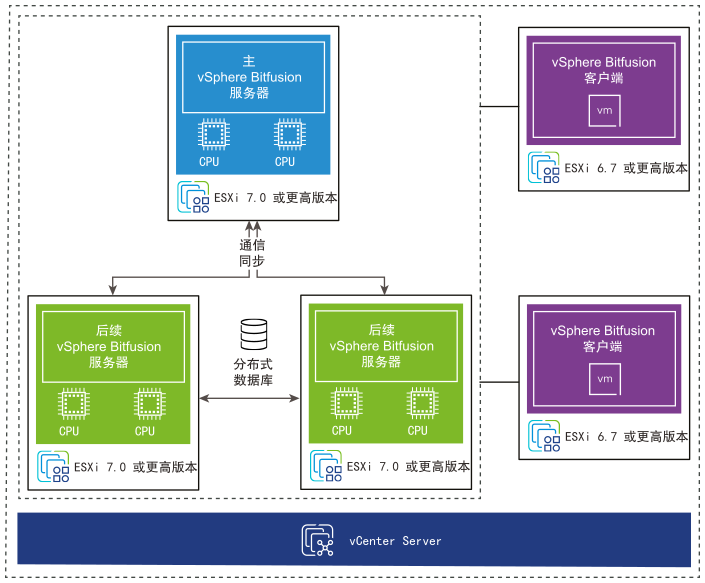

VMware vSphere GPU虚拟化Bitfusion 安装参考指南

VMware vSphere GPU虚拟化Bitfusion 安装参考指南