vSAN建立前的准备工作

部署vSAN时,除了至少必须有三部ESXi主机以及位于相同的集群中外,每部主机的版本也必须相同,且至少有一块SSD作为快取使用,一块HDD当作容量(资料)硬盘使用,以形成所谓的混合配置。当然,若全部皆采用SSD以形成All Flash配置,那么运行的效能将达到最巅峰。

在混合配置的集群架构中,vSAN将全部可用快取的70%配置给读取快取,30%配置给写入缓冲区。若是在All Flash的集群架构中,则一个指定的SSD装置将当作写入快取,其他SSD装置将用于容量。必须注意的是,无论采用何种架构,其硬盘皆不能再被用于其他用途,例如VFFS、VMFS等等。

在内存需求部分,取决于每部主机的硬盘群组与硬盘装置的数量,最小需求是8GB,若以32GB的内存来说,将可容纳最多5个硬盘群组,而每个硬盘群组则容纳7个硬盘装置。

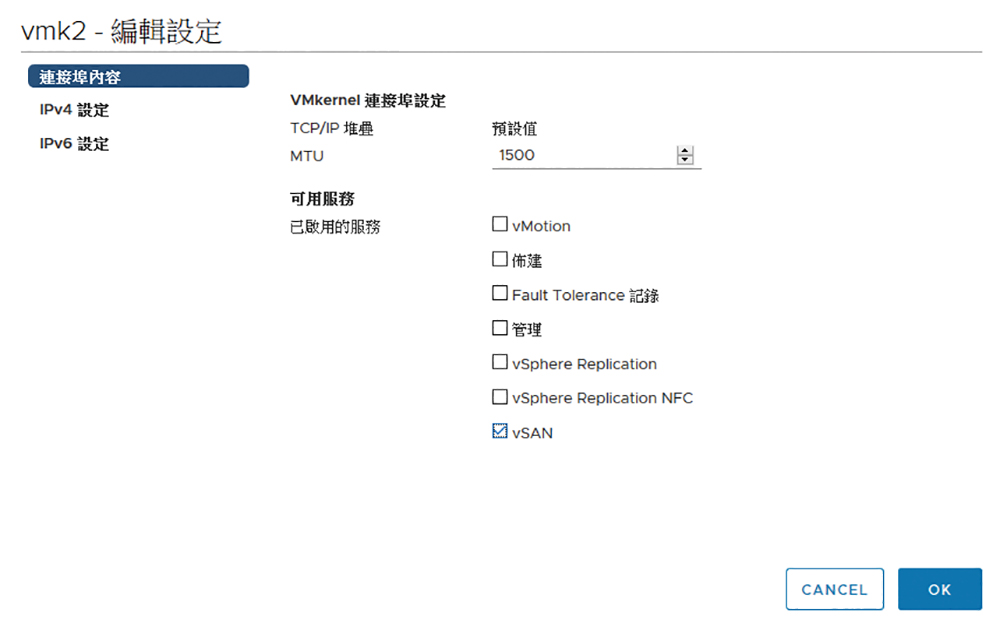

在网络的准备上,如果vSAN的规划打算使用混合配置(SSD HDD),只需要准备1Gbps的专用网络连接。如果是要采用高效能的All Flash组态(SSD),则连接专用的10Gbps网络。接着,还必须在vSphere的配置中,将每部ESXi主机专属用于vSAN的VMkernel网络介面卡,如图1所示启用vSAN流量的服务选项。

▲图1 设定VMkernel连接埠。

▲图1 设定VMkernel连接埠。

如果打算在现行的集群中启用vSAN功能,必须注意此集群是否已经启用「vSphere HA」功能。如图2所示,如果发现在「编辑集群设定」页面内已启用了此项功能,请先予以关闭,否则后续启用vSAN功能时会出现错误讯息。

▲图2 编辑集群设定。

▲图2 编辑集群设定。

开始建立vSAN

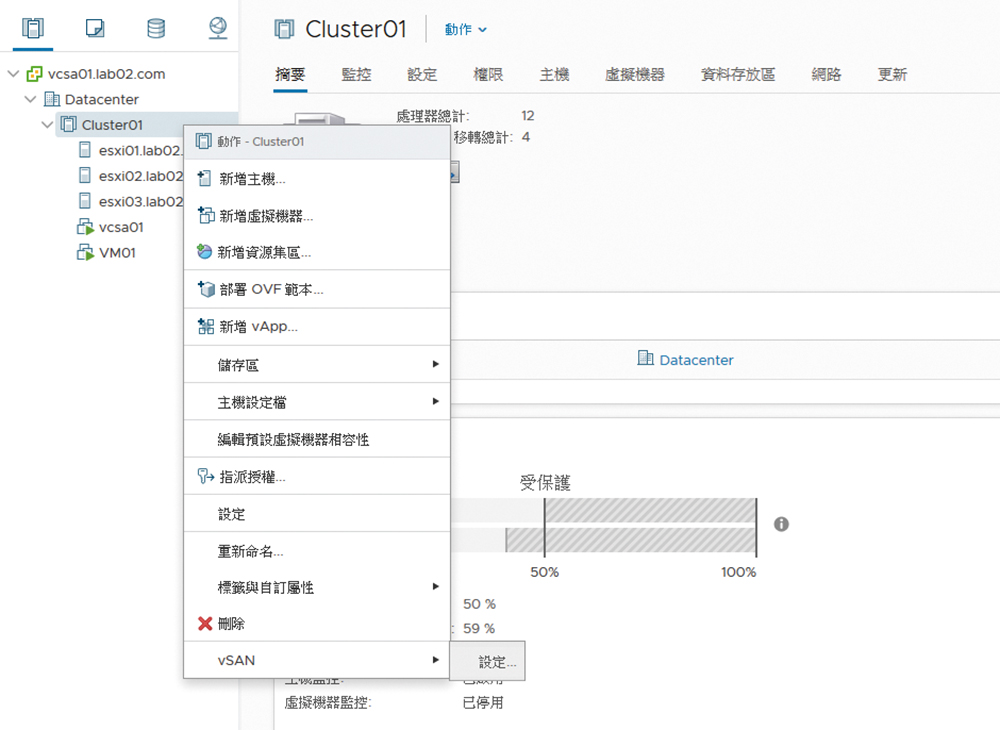

一旦准备好vSAN所需要的基础环境,包括ESXi主机、本机硬盘、网络以及集群后,就可以在如图3所示的集群节点上按下鼠标右键,待开启快速选单后,依序点选【vSAN】子选单中的【设定】。

▲图3 启用集群右键选单,依序点选【vSAN】→【设定】。

▲图3 启用集群右键选单,依序点选【vSAN】→【设定】。

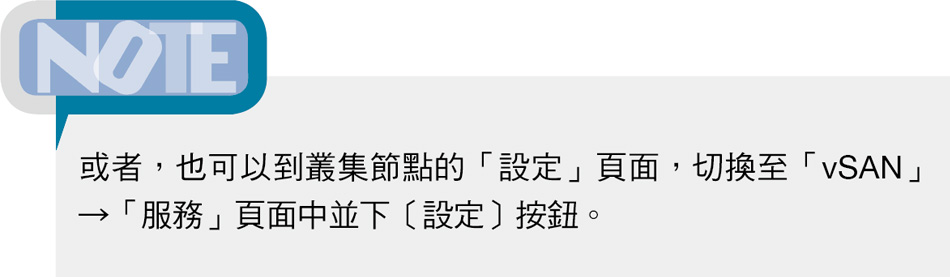

如图4所示,在「组态类型」页面中将有三个选项,说明如下:

▲图4 指定组态类型。

▲图4 指定组态类型。

‧单一站台集群:当所有主机位于同一个站台并且需要共用见证功能,可以选择此类型,而每台主机也会被视为存放于自己的容错网域中,本范例选此类型。

‧包含两台主机的vSAN集群:让两部提供储存功能的主机位于相同站台中,而让仅担任见证功能的主机在另一个站台中运行,它将只会负责存放见证用的中继资料。

‧延伸集群:提供两个作用中的资料站台,其中每个站台都有偶数台主机与储存装置,并且将见证主机位于第三个站台中。

如图5所示,在「服务」页面中可以决定是否要在vSAN的储存区中启用重复资料删除和压缩功能,而必须注意的是,此项功能必须在All Flash硬盘配置下才能够正常地使用,因为目前尚未支援混合硬盘配置的架构。

▲图5 进行服务设定。

▲图5 进行服务设定。

进一步地,若想要启用加密功能,则必须预先设定KMS集群的连线,然后在此页面中选定并决定使用前是否要清除硬盘。至于「允许减少的冗余」选项,其用途在于当有变更重复资料删除、压缩或是加密状态时,vSAN可以视需要降低虚拟机器的保护层级。设定完毕,再按下〔下一步〕按钮。

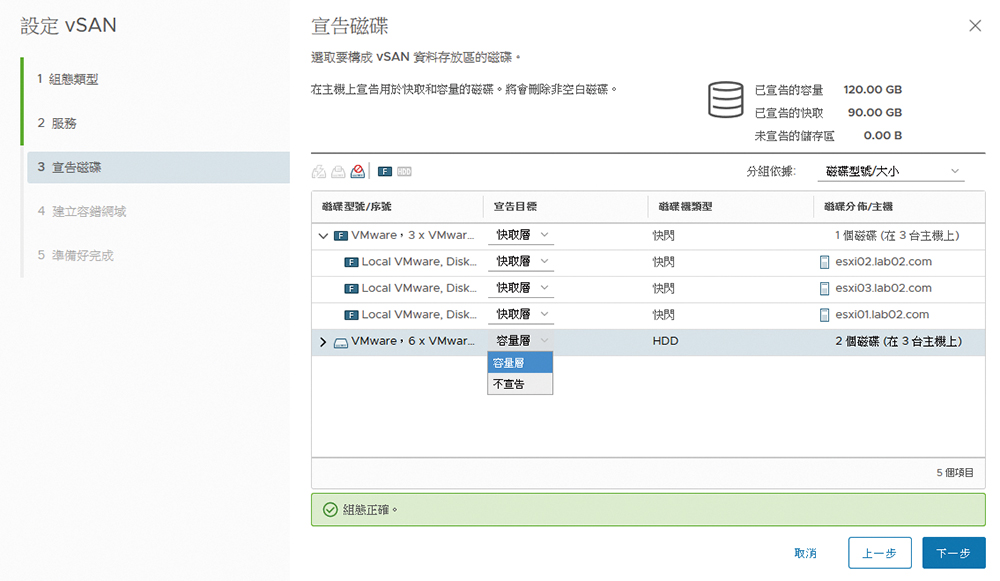

随后来到「宣告硬盘」页面,如图6所示为每一个硬盘选择宣告为快取层或是容量层。若是暂时不加入vSAN储存区,则选取【不宣告】。完成设定后,系统会自动计算出快取层与容量层的可用空间。按下〔下一步〕按钮继续。

▲图6 宣告硬盘。

▲图6 宣告硬盘。

接着是「建立容错网域」页面,可根据实际的需要来建立多个容错网域。所谓的容错网域(Fault Domain)便是打从vSAN 6.0版本开始所新增加的功能,主要目的在强化除了硬盘、网络以及主机外的容错能力,进一步解决因整个机柜(Rack)发生故障或断电的容错问题。

举例来说,如果建立了两个容错网域来分别加入两个不同机柜的vSAN成员主机,一旦其中一个机柜因故停摆时,另一个机柜仍然可以继续提供vSAN的存放服务,非常适合规划在大型企业IT环境中。至于如果有主机不是选定为任一容错网域的成员,则vSAN会将视它为独立的容错网域。按下〔下一步〕按钮并确认以上设定无误后,按下〔完成〕按钮即可。

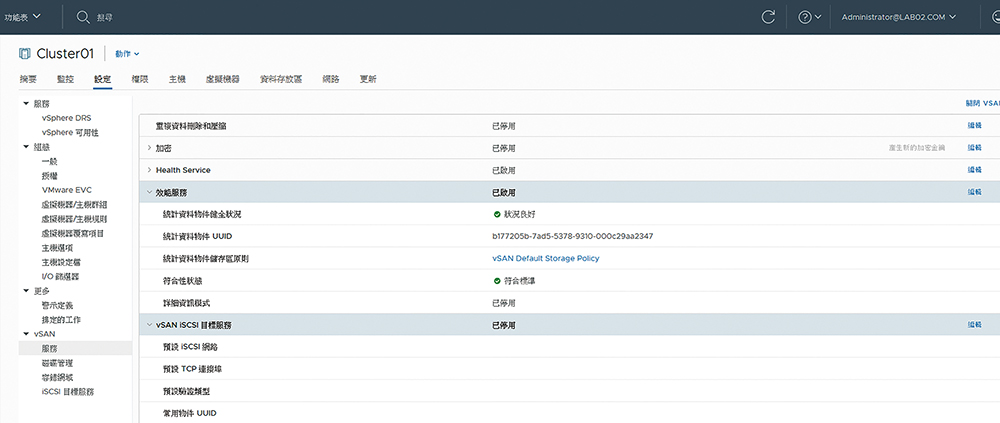

vSAN建立完成后,便可以在「vSAN」→「服务」页面内查看vSAN服务下的各项功能启用状态,如图7所示包括重复资料删除和压缩、加密、健康服务、效能服务、iSCSI目标服务。换句话说,除了针对vSAN的主体服务进行启用或关闭外,也可以仅只对上述的这些功能依照实际需求进行个别的启用或关闭。

▲图7 管理vSAN服务。

▲图7 管理vSAN服务。

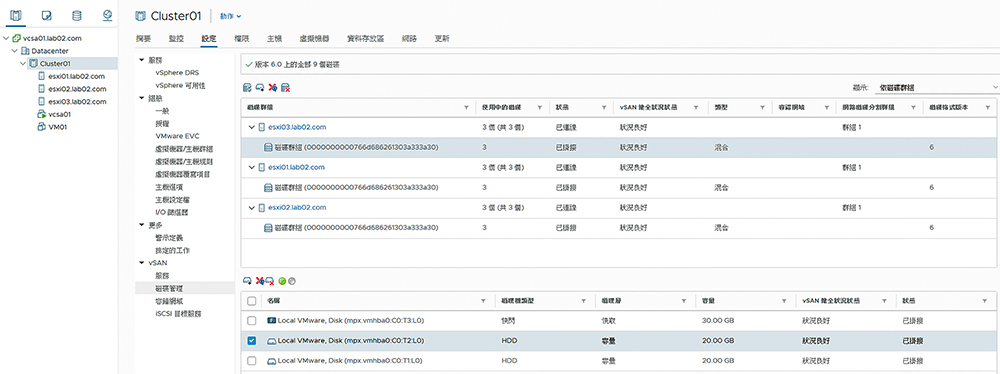

在vSAN的硬盘管理部分,如图8所示,在「vSAN」→「硬盘管理」页面中能够新增删除硬盘群组或群组内的硬盘。值得注意的是,即便执行了删除操作,也能够将相关资料撤除至其他主机或硬盘来继续使用,以维持在这上面运作的虚拟机器或其他外部系统的正常存取。

▲图8 vSAN硬盘管理。

▲图8 vSAN硬盘管理。

vSAN硬盘群组管理

当陆续新增加的虚拟机器开始善用vSAN资料存放区所带来的各项好处时,IT人员最常面临的问题往往是可用的存放空间即将不足,该如何因应呢?记得笔者过去曾经讲解过,对于ESXi主机本机或iSCSI存放空间不足时的解决方法,皆是在增加实体硬盘后,再来完成资料存放区的扩充设定。

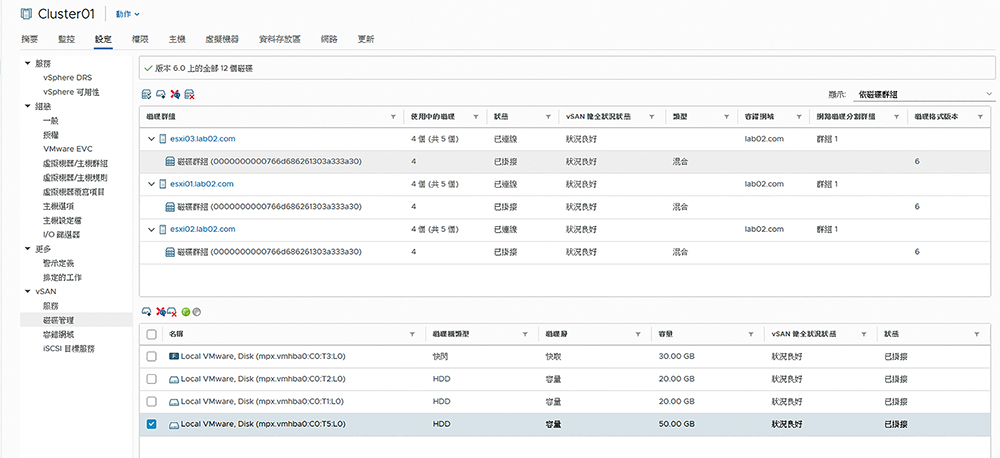

然而,在vSAN 6.7的架构下做法将有些不同。在「vSAN」→「硬盘管理」页面中,先选取已经完成增加实体硬盘的ESXi主机之硬盘群组,再点选下方的「将硬盘新增至选取的硬盘群组」小图示,便会开启「新增容量硬盘」页面,如图9所示将呈列出该主机中所有尚未使用的本机硬盘,只要勾选要加入vSAN的硬盘并按下〔新增〕按钮即可。

▲图9 新增硬盘至群组。

如图10所示,接着便可以于硬盘群组内看到刚新增的本机硬盘,在此可以检视到硬盘群组中每一块硬盘的类型、用途、容量、健康状况以及是否挂接,若发现呈现故障的硬盘,也可以在这里进行移除。

▲图10 管理硬盘群组。

▲图10 管理硬盘群组。

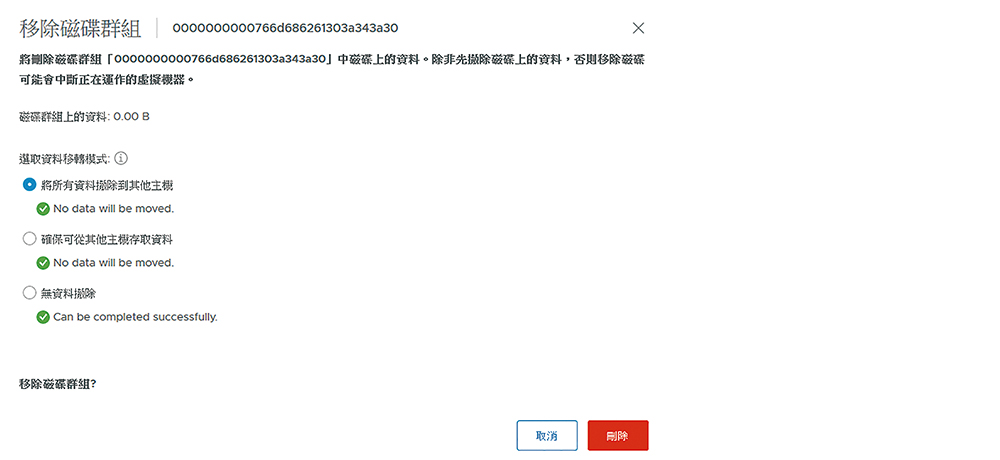

除了可以移除个别硬盘外,必要时也可移除整个硬盘群组,不过这可能会影响现行存放的资料,因此执行时会出现如图11所示的设定页面。在此必须决定资料移转模式,例如选取「将所有资料撤除到其他主机」。如果选取「无资料撤除」,那么在撤除期间若发生故障,相关资料可能会因此遗失。

▲图11 移除硬盘群组。

▲图11 移除硬盘群组。

vSAN健康诊断

「天有不测风云,人有旦夕祸福」,在虚拟化的运作环境中也会存在各式各样的风险。就以vSphere整体架构来说,vSAN是最重要的一环,因为它存放了虚拟机器的重要档案,甚至于也可能包含来自其他异质系统的档案。

因此,除了在网络与硬体层面的高可用性设计需要妥善规划外,定期持续的健康状况检查肯定也是必要的。

如何在vSphere Client网站上透过内建的健康检查服务来定期监视vSAN的整体运作状况呢?如图12所示,在集群节点的「监控」→「vSAN」→「服务」页面中,按下〔编辑〕按钮来选择停用或启用「Health Service」功能,并且可以修改「健全状况检查时间间隔」设定。

▲图12 vSAN服务管理。

▲图12 vSAN服务管理。

一旦启用vSAN健全状况检查功能后,若Health Service服务在定检中发现vSAN有某个环节的健康问题,该集群节点的图示除了会出现红色的警示符号外,在其「摘要」页面内也会显示「vSAN健全状况警示」的相关讯息,例如出现了与统计资料库物件有关的讯息。只要该问题在获得解决后,便可以针对该警示讯息点选「重设为绿色」,即可消除警示。

此外,在vSAN集群的「摘要」页面内,如图13所示还能够查看到目前vSAN运行状况的概观,包括vSAN的容量、健全状况以及效能的最新数据统计,若要查看进一步的详细资讯,只要点选「详细资料」超连结即可。

▲图13 检视集群摘要。

▲图13 检视集群摘要。

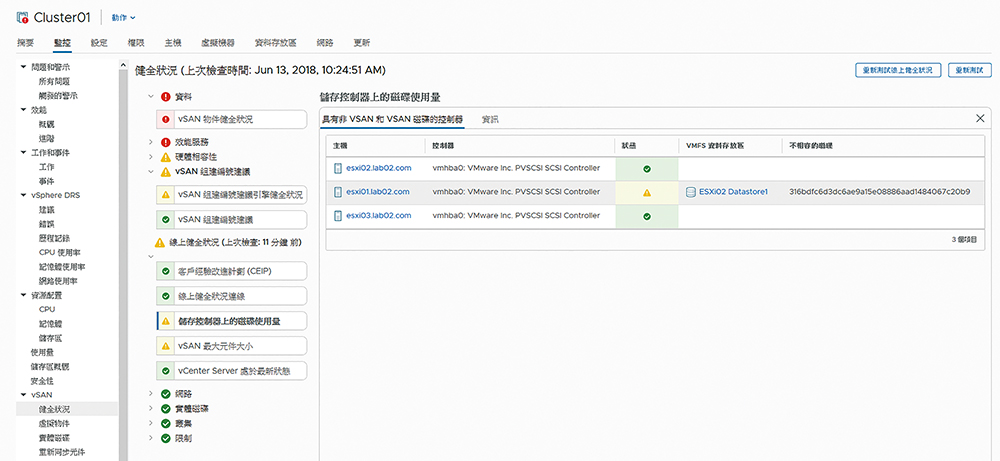

对于vSAN最新一次的完整健康状态报告,要从哪里开启呢?在vSAN集群的「监控」→「健全状况」页面中,如图14所示,主要会检查的类别包括硬体相容性、效能服务、网络健全状况、实体硬盘、vSAN资料以及集群的健全状况、集群限制、线上健全状况、vSAN组建编号建议、vSAN iSCSI目标服务、加密状态以及延伸集群运行状态。

▲图14 检视vSAN健全状况。

▲图14 检视vSAN健全状况。

上述这些健康状况的检查,皆是由vSAN自动定期进行测试与回报(预设60分钟),如果想要立即进行健康测试,按下〔重新测试〕按钮即可。此外,必须注意其中的「线上健全状况」功能之使用,必须有参与「客户经验改进计画」才能够让健全状况检测功能将相关资料传送至VMware,以供完成进阶分析的任务。若已经参与,则可以按下〔重新测试线上健全状况〕按钮。

关于vSAN健康状况的检查结果,举例来说,若系统发现目前非vSAN与vSAN的硬盘共用了一张相同的储存控制卡(Storage Controller),在「储存控制器上的硬盘使用量」分类页面中便会出现黄色的警示图示。此时可以透过「资讯」页面内的相关超连结来进一步开启官网上的知识库(KB),查看原厂所提供的解决方案。

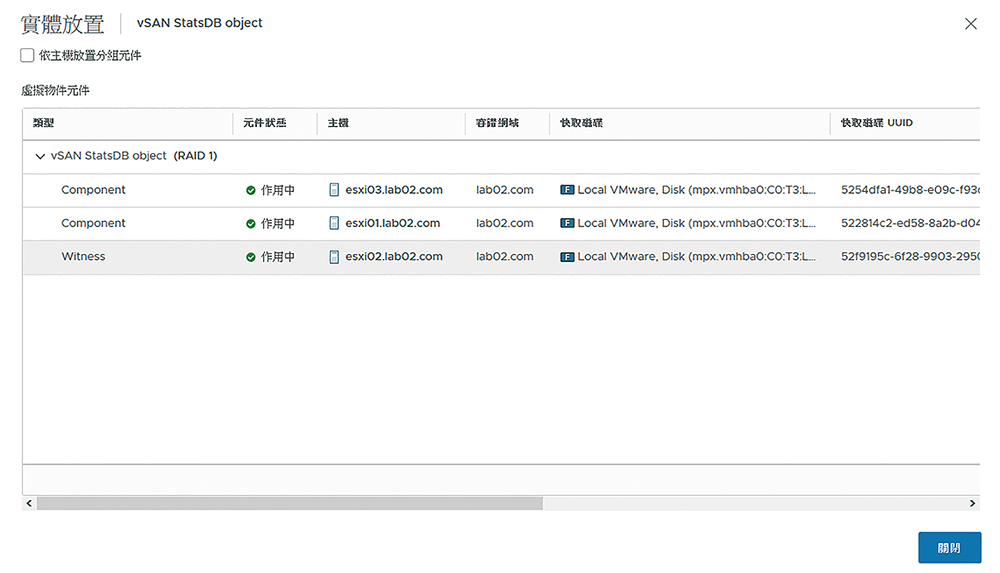

接下来,查询在目前vSAN的架构中究竟是哪一部ESXi主机负责担任见证(Witness)的角色,以维持主机高可用性的持续运作。在「vSAN」→「虚拟物件」页面中点选「检视放置详细资料」超连结,如图15所示将开启「实体放置」页面,便可以检视到每一部ESXi主机所属的容错网域及担任的角色。

▲图15 检视实体放置详细资料。

▲图15 检视实体放置详细资料。

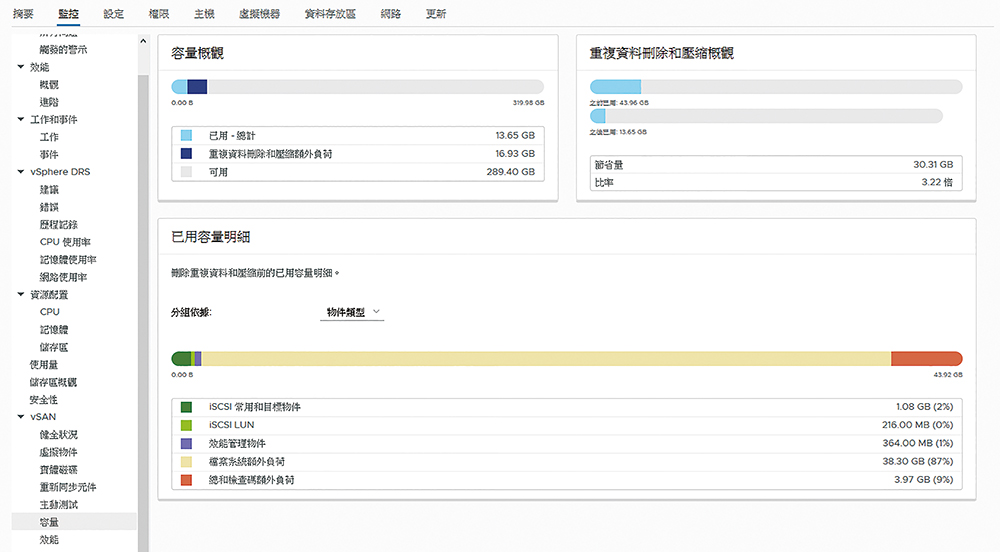

接着,在vSAN集群监视的「容量」页面中,检视整体的容量概观、重复资料删除和压缩概观、已用容量明细,如图16所示。其中已用容量明细的分组依据,分别有虚拟硬盘、虚拟机器常用物件、分页物件、效能管理物件、Vmem物件、档案系统额外负荷、总和检查码额外负荷、重复资料删除和压缩额外负荷、重复资料删除引擎下的空间考量事项、iSCSI常用与目标物件、iSCSI LUN,以及其他像是使用者建立的档案、虚拟机器范本等等。

▲图16 查看容量分析报告。

▲图16 查看容量分析报告。

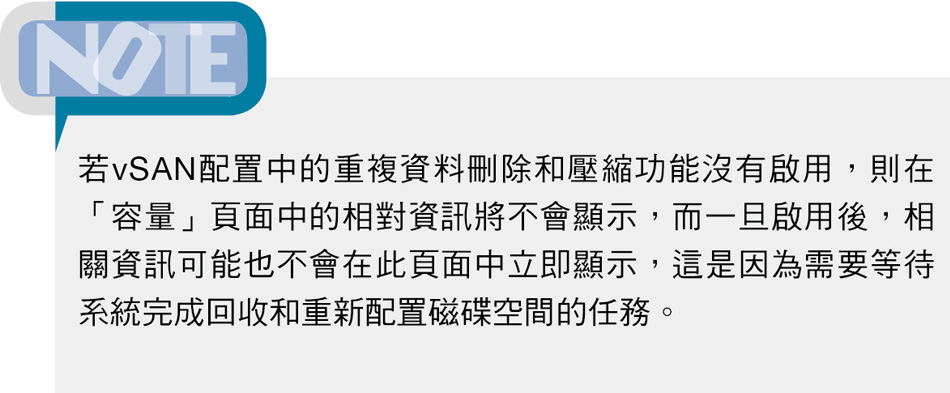

对于vSAN运作状况的监视,除了可以从集群节点的「监视」页面来查看相关数据外,也能够到ESXi主机节点的「监控」页面中检视。首先,在「vSAN」→「健全状况」页面内可以得知线上健康(Online health)状况。若切换到如图17所示的「vSAN」→「效能」页面中,则可以按照虚拟机器、后端、硬盘、实体介面卡、主机网络以及iSCSI子页面来查看各自运行的效能表现。以「硬盘」页面范例来说,便可以查看到目前有关客体(Guest OS)IOPS、客体延迟时间、客体输送量、读取快取命中率等数据分析。

▲图17 从主机端检视vSAN效能。

▲图17 从主机端检视vSAN效能。

哪一些事件会让vSAN集群触发重新同步?答案是主机或网络故障、主机进入维护模式、虚拟机器储存区原则异动,以及当vSAN集群中的容量装置使用量接近或超出80%的临界值时。如果虚拟机器因重新同步任务而导致回应延迟或是无回应,管理员可调整用于重新同步的IOPS配置。

建立虚拟机器于vSAN储存区

将虚拟机器建立在以vSAN为主的超融合式基础架构,可以为虚拟机器的运行带来许多好处,例如使用储存区所需要的HA、vMotion以及DRS等高可用性功能,以及轻松延伸刀锋型伺服器环境中的JBOD硬盘储存区、自由选择存放在以All Flash或混合组态的vSAN集群等等。接着就来实际操作一下,将新建的虚拟机器选定存放在vSAN的储存区内。

首先,在vSAN集群节点上按一下鼠标右键,开启快速选单后点选【新增虚拟机器】。接着,在「选取名称和资料夹」页面内输入新虚拟机器名称并选择位置,并按下〔NEXT〕按钮。随后开启「选取计算资源」页面,可选择集群或直接选定ESXi主机,决定好了之后按下〔NEXT〕按钮。

如图18所示,在「选取储存区」页面中便可以看到一个名为「vsanDatastore」的Virtual SAN类型储存区,必要的话也可以在此变更即将套用的虚拟机器储存原则。按下〔NEXT〕按钮,进行后续设定。

▲图18 新增虚拟机器。

▲图18 新增虚拟机器。

来到「选取相容性」页面后,选择所要采用的虚拟机器版本,预设为最新的ESXi 6.7或更新版本。按下〔NEXT〕按钮继续,接着在「选取客体作业系统」页面内选择以Windows或Linux为主的作业系统版本。值得注意的是,若在上一个步骤中所选择虚拟机器版本越新,在此相对所支援选择的客体作业系统版本也会越新。按下〔NEXT〕按钮,继续设定。

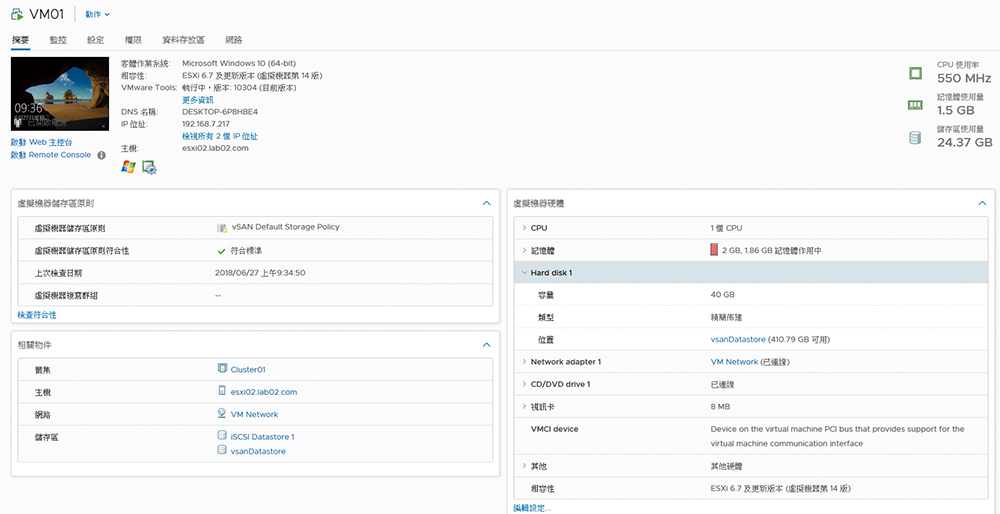

在完成「自订硬体」页面中的各项设定,如CPU、内存、硬碟以及网络连线等设定并按下〔NEXT〕按钮后,便会来到「即将完成」页面,确认无误后按下〔FINISH〕按钮,就完成新虚拟机器的建立了。图19所示便是一个新虚拟机器的「摘要」页面,在此除了可从「虚拟机器硬体」的资讯中看到虚拟硬碟的存放位置正式vSAN储存区外,还能够从「虚拟机器储存区原则」资讯中查看到目前所套用的vSAN储存区原则,以及是否已符合该原则的标准。而当原则有进行过修改时,还可以利用「检查符合性」超连结,立即确认是否符合标准。

▲图19 检视虚拟机器运行状态。

▲图19 检视虚拟机器运行状态。

建立vSAN iSCSI目标服务

vSAN除了支援在vSphere架构中各项解决方案的使用如vSphere Replication、vMotion、Storage vMotion等功能,以便让虚拟机器享有高可用性的运行外,也可以进一步透过其内建的iSCSI Target服务功能来提供外部各种有HA架构需求的异质系统使用,例如前面曾提及的WSFC、Exchange DAG以及SQL Server AAG等等。

其实,无论是想要在vSAN储存区仅存放虚拟机器档案,还是要进一步透过其内建的iSCSI Target服务来存放更多来自异质系统的资料或档案,除了需要考量到vSAN本身的配置外,还得调整适当的虚拟机器储存区原则进行套用,以满足不同资料层级的安全性与可用性需求。

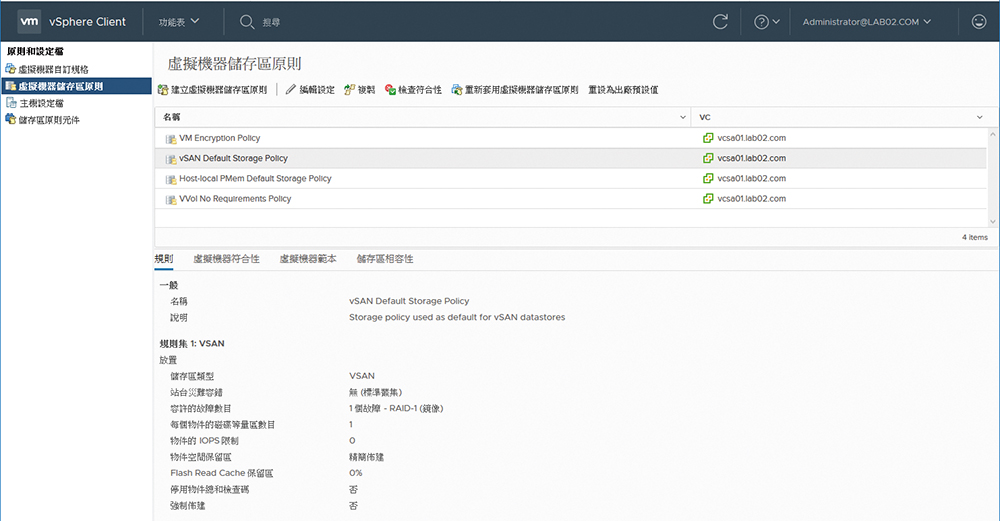

可以从vSphere Client网站的「捷径」页面中来开启它。如图20所示,在此每一种不同用途的预设虚拟机器原则,可以选择修改现行的原则或是新增自订的原则,以vSAN储存区的原则配置而言,可因应架构规模的大小与高可用性的需求,调整相对的站台灾难容错、硬盘容许的故障数目、空间保留区以及对于IOPS的限制等设定。

▲图20 虚拟机器储存区原则管理。

▲图20 虚拟机器储存区原则管理。

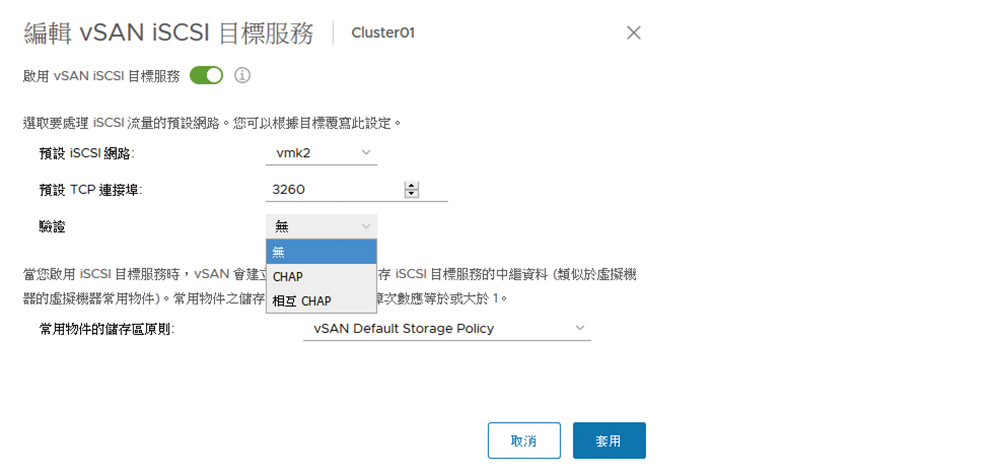

在确认了虚拟机器储存区原则的配置后,接下来就可以尝试启用vSAN的iSCSI Target服务。首先,在「集群」节点的「设定」→「iSCSI目标服务」页面中,点选「启用」超连结来开启如图21所示的「编辑vSAN iSCSI目标服务」页面。这里可以选取预先准备好的iSCSI专用网络,再决定是否要使用提供连接时的验证功能(CHAP或相互CHAP)。最后,再挑选所要套用的储存区原则,并按下〔套用〕按钮即可。

▲图21 启用vSAN iSCSI目标服务。

▲图21 启用vSAN iSCSI目标服务。

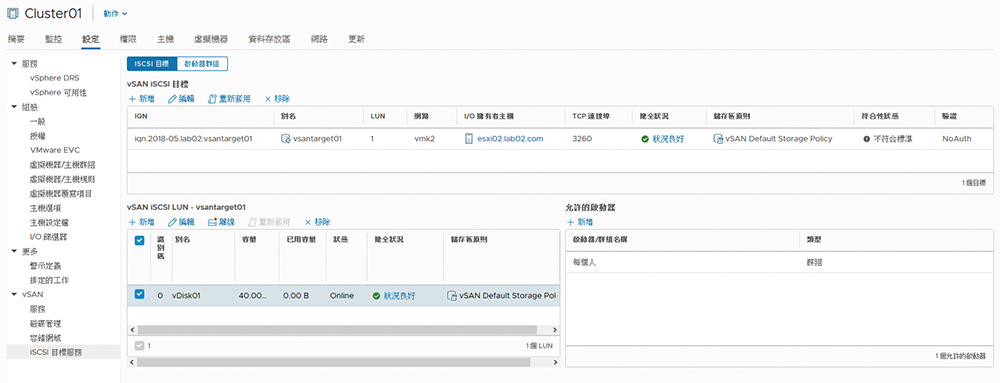

完成启用vSAN iSCSI目标服务后,将可以继续在「iSCSI目标」页面中点选「新增」超连结,来开启「新增iSCSI目标」的设定页面。首先必须设定IQN识别码,可以选择保留空白,由系统稍后自行产生。若要手动输入IQN识别码,其格式为「iqn.YYYY-MM.domain:Name」,其中冒号(:)后的名称输入为选用,适合在建立多个iSCSI目标时识别用,建议输入主机名称。

在「别名」栏位部分,建议输入与前面的Name名称相同的设定值。完成储存区原则、网络、TCP连接埠以及验证的设定后,按下〔确定〕即可。完成iSCSI目标的建立后,还必须至少建立一个以上的iSCSI LUN,才能够让前端欲连接的系统来存取。

接着,在「vSAN iSCSI LUN」区域内点选「新增」超连结,来开启「新增LUN至目标」页面中,在此依序完成识别码、别名、储存区原则以及空间大小的设定,最后点选〔新增〕。

图22所示便是已完成一个iSCSI目标与一个LUN的vSAN iSCSI目标服务的页面范例,可依实际需求继续新增更多的iSCSI目标与LUN,或是修改现行的设定。值得注意的是,若某一个LUN暂时不开放存取,只要点选「离线」即可,等到需要继续提供存取时再点选「线上」。

▲图22 vSAN iSCSI目标管理。

▲图22 vSAN iSCSI目标管理。

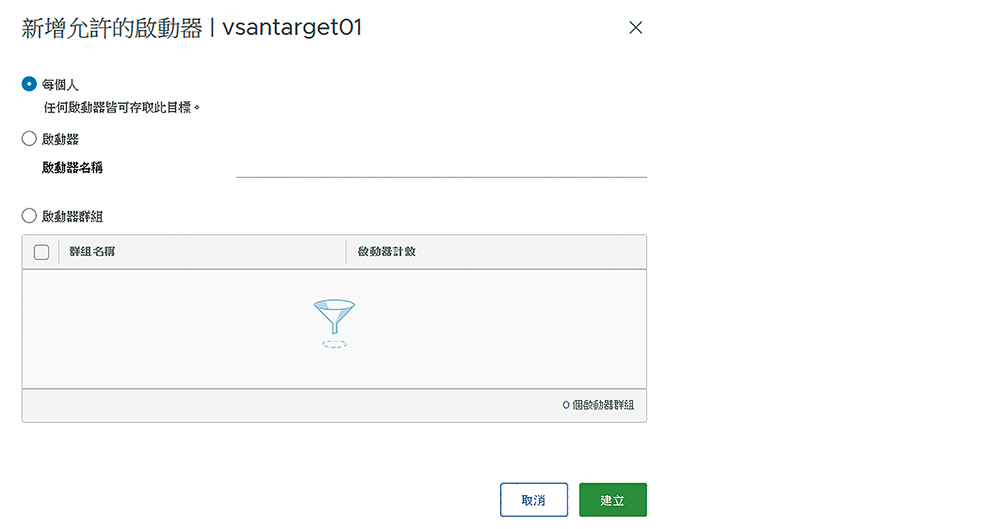

为了安全起见,建议进一步在「允许的启动器」区域内点选「新增」,然后在「新增允许的启动器」页面中,将预设的「每个人」选项改选为指定的「启动器」并输入名称,如图23所示。最后,按下〔建立〕按钮。

▲图23 管理允许的启动器。

▲图23 管理允许的启动器。

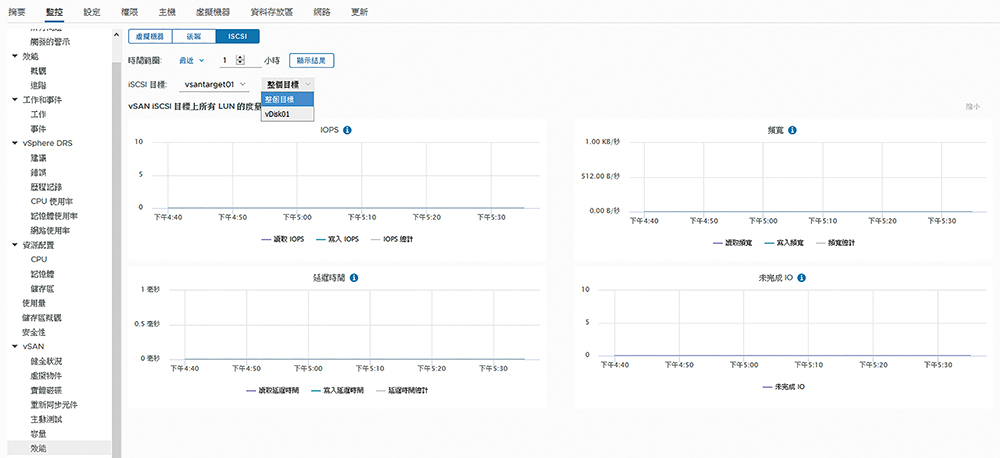

在vSAN整体的运行中,提供了对于iSCSI目标服务的效能监视。如图24所示,可在「监控」→「vSAN」→「效能」节点中,点选至「iSCSI」页面来查看选定的iSCSI目标与LUN的效能状态,包括IOPS、频宽、延迟时间以及未完成IO。

▲图24 针对vSAN iSCSI目标效能监视。

▲图24 针对vSAN iSCSI目标效能监视。

针对IT人员对于vSAN运作的维护管理,现阶段除了可以透过vSphere Web Client或vSphere Client(HTML)外,也可经由「esxcli vsan」相关命令参数进行诸如网络、储存、集群、健康状态以及除错资讯的检视与配置调整。

举例来说,如果想要查看有关于vSAN的储存装置清单,只要执行「esxcli vsan storage list」命令即可。若要查看vSAN运行的最新健康状态,则执行「esxcli vsan health」命令。

设定Microsoft iSCSI启动器

基本上,只要完成vSAN iSCSI Target服务与LUN的配置,任何被授予权限存取的系统都可以透过iSCSI Initiator来连接相对的LUN储存区。

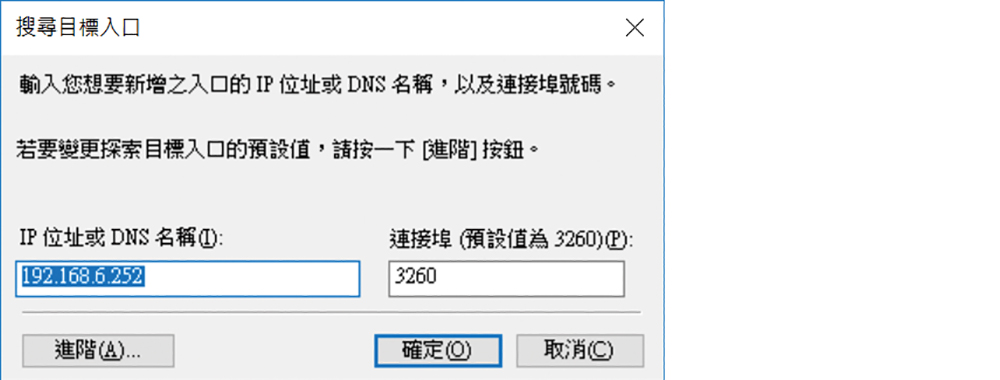

这里以Windows Server 2016为例,开启「控制台」的「iSCSI启动器」程式。首次执行将会出现是否要让此服务在每一次作业系统重新启动时自动启动,请按下〔是〕按钮继续。接着切换至「探索」页面并按下〔探索入口〕按钮,将开启如图25所示的「搜寻目标入口」,确认vSAN iSCSI Target位址与连接埠设定正确后按下〔确定〕按钮即可。

▲图25 查询iSCSI启动器目前连线。

▲图25 查询iSCSI启动器目前连线。

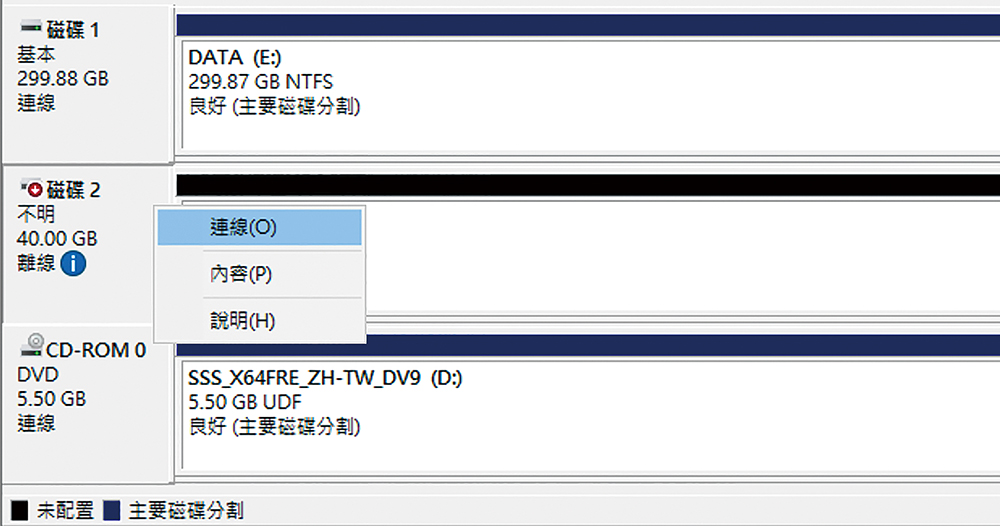

一旦iSCSI启动器成功连线iSCSI目标后,开启作业系统的「硬盘管理员」介面,如图26所示便可以查看到已成功连接的LUN硬盘。此时只要在这些硬盘上按下鼠标右键并点选快速选单中的【连线】,即可开始进行硬盘初始化与硬盘区的建立。此外,也可以在多部Windows Server主机的架构下,配置集群以及各种高可用性架构的部署。

▲图26 连线iSCSI硬盘。

▲图26 连线iSCSI硬盘。

进行iSCSI启动器MPIO设定

由于iSCSI对于资料的传递与储存皆是透过网络来完成,因此当连接的路径只有一条时,便可能会因网络线、网卡或是所连接的网络交换机故障,导致iSCSI虚拟硬盘连线失败,进而造成集群或相关应用程式发生错误。

为了避免这一类的问题发生,一般而言,无论是在哪一种iSCSI网络的架构下,都强烈建议让iSCSI Initiator藉由启用多重路径功能(MPIO)来避免单一路径失败的窘境。

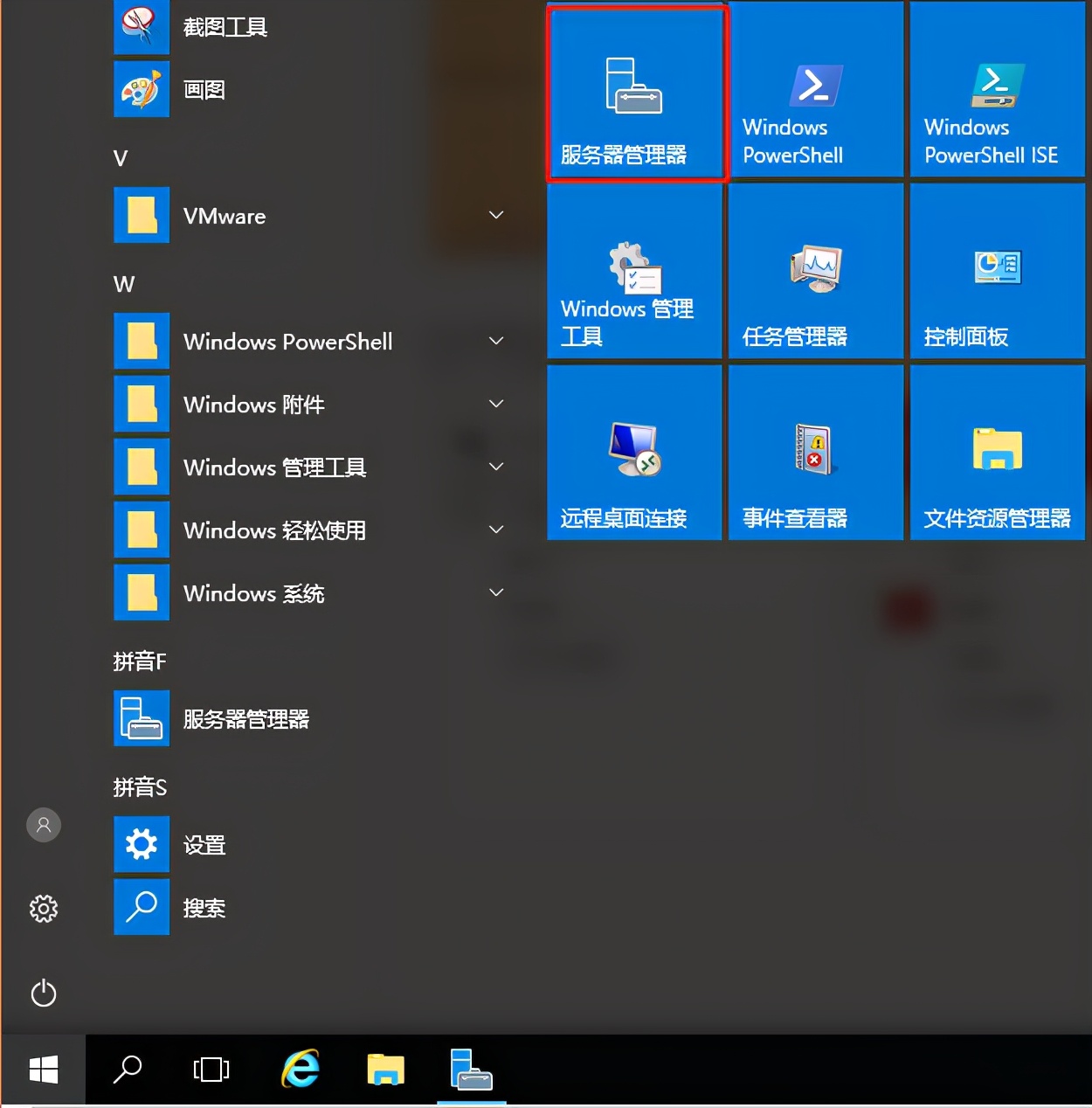

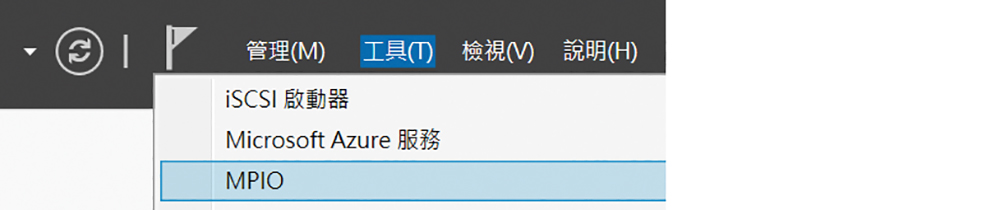

想要在Windows Server 2016中使用iSCSI Initiator多重路径功能相当容易。只要在「伺服器管理员」介面中,完成安装「多重路径I/O」功能,便可以如图27所示在「工具」选单中点选开启「MPIO」的设定页面。

▲图27 使用伺服器管理员工具。

▲图27 使用伺服器管理员工具。

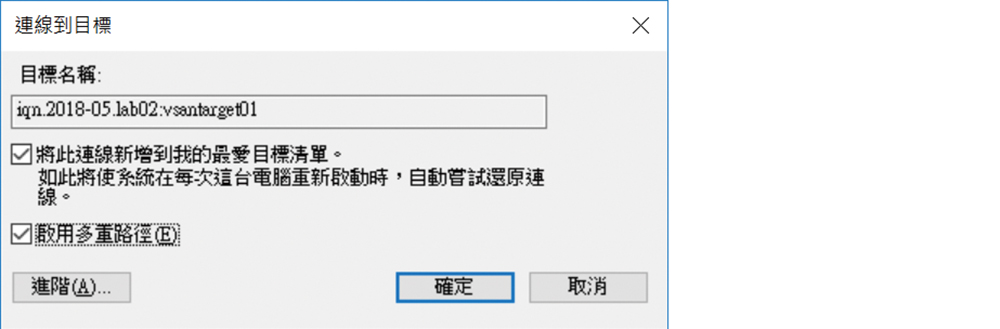

开启MPIO的设定页面后,只要将「探索多重路径」页面内的「新增iSCSI装置的支援」选项勾选,并重新启动主机即可。在作业系统重新启动后,再次开启「iSCSI启动器」。接着,同样按下〔探索入口〕按钮。此时会跳出一个「连线到目标」视窗,如图28所示,先勾选「启用多重路径」选项再按下〔进阶〕按钮。

▲图28 连线到目标。

▲图28 连线到目标。

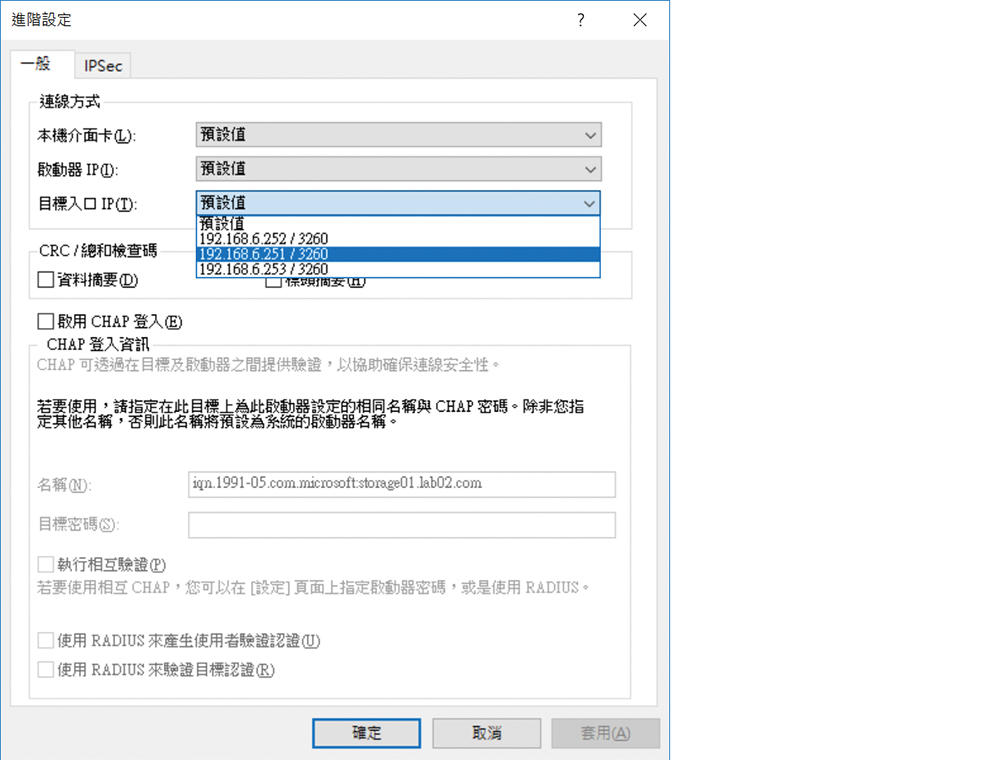

随后,如图29所示在「进阶设定」页面中设定各自的连线路径,这项设定必须根据实际可用的路径多寡来决定所要新增的目标连线设定数量。可以设定连线的「启动器IP」和「目标入口IP」,这样一来,不同的启动器IP便能够对应到不同的目标入口IP,进而达到多重路径的效果。

▲图29 进行进阶设定。

▲图29 进行进阶设定。

成功完成各个网络路径的iSCSI目标连线设定后,在「目标」页面内按下〔内容〕按钮,就能够在「工作阶段」页面中查看到目前已经连线的目标资讯,可以随时在此中断任何一个工作阶段(Session)的连线。若想自订MPIO负载平衡原则,则在按下〔装置〕按钮后进行挑选即可。

结语

早期版本的vSAN仅能作为VMware vSphere自家专属的Datastore,如今却已经可以藉由内建的iSCSI Target服务,让其他异质系统经由iSCSI Initiator的连接,来共同享有vSAN 6.7所带来的各项储存管理效益,这意味着未来的云端虚拟化平台无论品牌为何,都将会逐渐迈向大融合的管理趋势。

换句话说,从虚拟机器的移转、复制、备份到HA的各项运作机制,皆有可能达到彼此相互支援的局面。如果真的有这么一天,那么对于IT部门来说肯定是一件好消息,毕竟在真实的IT维护环境中,混合各家品牌的硬体与系统早已是见怪不怪了。

允许随意转载;但,请点赞!点赞-NMBHOST:NMB HOST » 实战部署vSAN 6.7 打造跨ESXi主机储存池